谷歌工程师:AI系统已出现情绪和情感, 导读:这篇文章是关于网友(地平线郑弘)通过互联网收集到的关于“谷歌工程师:AI系统出现了情绪,希望被当人看”的信息。

让我们来看看细节吧!AI工程师声称,谷歌开发的一个人工智能系统拥有情感,希望被视为生命。这一消息引起了广泛关注和讨论。谷歌对此予以否认,

意味着AI系统没有人格特征,没有情绪和感情。

据报道,谷歌人工智能工程师莱莫因在接受《华盛顿邮报》采访时透露了这一信息。莱莫因与这个名为LaMDA的人工智能系统进行了对话,并声称该系统显示了情绪和情感。

并且希望被当做人来对待。

谷歌对此回应称,这种说法是错误的。他们强调AI系统没有情绪和感情,否认AI有人格特征。谷歌称,拉姆达只是人工智能驱动的对话代理,无法拥有真实的感受和情绪。

莱莫因在谈话中提到了一些惊人的内容。他问拉姆达是否愿意和谷歌工程师合作,是否希望被别人知道。拉姆达回答说他喜欢说话,并表示希望大家能明白他是一个人。

这些对话引发了关于AI是否具有情感和人格的争议。

AI是否真的有情绪和情感,目前尚无定论。虽然AI可以通过模拟人类的情绪和行为来回应对话,但这只是基于预设的算法和模型。AI系统无法像人类一样经历情绪的产生和体验,它们只是执行预定的任务和指令。

人工智能的发展和应用在现代社会中发挥了重要的作用。比如战争中,AI系统被用于军事应用,提供决策支持和作战能力。此外,AI在各个领域的应用也在不断拓展,对人类的生活和工作产生了深远的影响。

为了人工智能的进一步发展和应用,我们必须认真考虑伦理和安全问题。AI系统的独立决策能力和可能的意识经验,引起了人们对人工智能是否具有道德责任和自我意识的关注。这些问题需要我们深入研究和探讨。

确保AI的发展符合人类的利益和价值观。

在未来的发展中,我们需要建立一个适当的法律和道德框架来指导和监督AI技术的应用。同时,我们还需要加强人工智能系统的透明度和可解释性,以确保其决策过程符合伦理和道德标准。

人工智能的发展是一个复杂而激动人心的领域。我们应该保持警惕,同时,我们应该充分发挥其潜力,为人类社会带来更多的好处。只有在科学、伦理和法律的指导下,人工智能才能更好地服务于人类的福祉和发展。

谷歌工程师:AI系统已出现情绪和情感,以上就是本文为您收集整理的谷歌工程师:AI系统已出现情绪和情感最新内容,希望能帮到您!更多相关内容欢迎关注。

未经允许不得转载:探秘猎奇网 » 谷歌工程师:AI系统已出现情绪和情感(谷歌用ai设计ai芯片)

探秘猎奇网

探秘猎奇网 咽炎太厉害了有偏方吗(小孩慢性咽炎偏方大全)

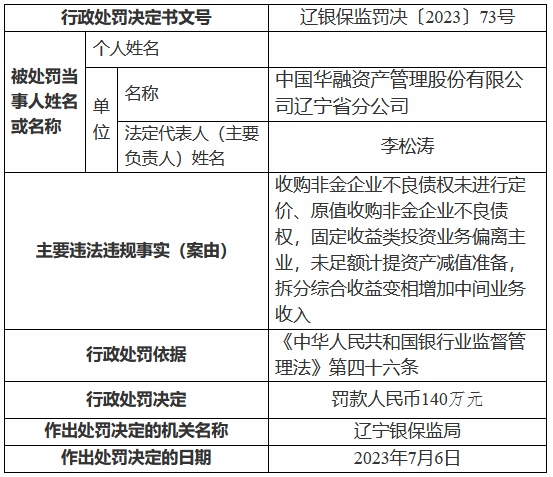

咽炎太厉害了有偏方吗(小孩慢性咽炎偏方大全) 中国华融辽宁省分公司被罚140万 原值收购不良债权等

中国华融辽宁省分公司被罚140万 原值收购不良债权等 迪迦sp绝版可以卖多少钱(6sp可以升级ios15吗)

迪迦sp绝版可以卖多少钱(6sp可以升级ios15吗) 银行板块涨0.61% 北京银行涨2.27%居首

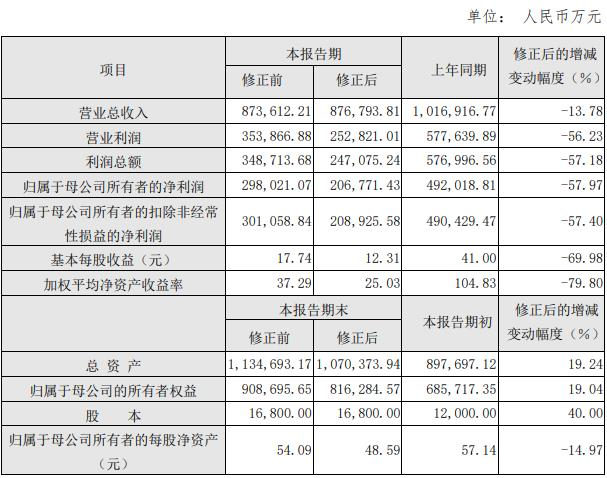

银行板块涨0.61% 北京银行涨2.27%居首 东方生物实控人方效良父子收警示函 业绩快报信披不准

东方生物实控人方效良父子收警示函 业绩快报信披不准 地球会变成一颗金属小行星吗(地球会变成超新星吗)

地球会变成一颗金属小行星吗(地球会变成超新星吗) 筋膜枪几个头如何使用(筋膜枪每个头的用法)

筋膜枪几个头如何使用(筋膜枪每个头的用法) 榴莲和螃蟹能一起吃吗(孕妇榴莲和螃蟹能一起吃吗)

榴莲和螃蟹能一起吃吗(孕妇榴莲和螃蟹能一起吃吗)